17 марта, 2015

Отчёт о проделанной работе, год 2014.

Мы все постоянно делаем разную полезную работу. А у любой работы должна быть высшая цель, а у высшей цели – критерий её достижения.

Мы спасаем мир от кибер-нечисти – хорошо или плохо? Абсолютно высшей цели и относительно других спасальщиков.

Для оценки успешности этой амбициозной задачи мы используем различные метрики. Одна из главных – независимая экспертная оценка качества наших продуктов и технологий. Чем лучше показатели, тем наши технологии лучше давят цифровую заразу и, объективно, лучше спасают мир :)

И кто это может сделать? Разумеется, независимые тестовые лаборатории! Но вот вопрос – как это всё обобщить? Ведь в мире проводятся десятки, сотни тестов всеми кому не лень!

Как из этой каши выжать самое правильное — то, что отражает максимально правдоподобную картину способностей сотен антивирусных продуктов? И исключить возможность тестового говномаркетинга? И сделать эту метрику понятной широкому кругу пользователей для осознанного и аргументированного выбора защиты?

Счастье есть, его не может не есть быть! Несколько лет назад мы вывели для себя следующую формулу оценки – «TOP3-рейтинг».

Как она работает?

Во-первых, нужно учитывать все известные тестовые площадки, проводившие исследование анти-зловредной защиты за отчётный период. Во-вторых, нужно учесть весь спектр тестов выбранных площадок и всех участвовавших вендоров. В-третьих, нужно брать в расчёт а) количество тестов, в которых вендор принял участие; б) % абсолютных побед и в) % призовых мест (TOP3).

Вот так — просто, прозрачно и по каждому пункту нечистоплотного тестового маркетинга (а такое, увы, частенько бывает). Конечно, можно навернуть ещё 25 тысяч параметров для добавления 0,025% объективности, но это будет технологический нарциссизм и гик-занудство – и тут мы точно потеряем рядового читателя… да и не очень рядового тоже. Самое важное – мы берём конкретный период, всю совокупность тестов конкретных площадок и всех участников. Ничего не упускаем и никого не щадим (включая себя).

Интересно? Дык! Давайте теперь натянем эту методологию на реальную энтропию мира по состоянию за 2014-й год!

Технические подробности и disclaimers, кому интересно:

- Учтёнными в 2014 году оказались исследования от восьми тестовых лабораторий. Они имеют многолетний стаж, технологическую базу (сам проверял), внушительное покрытие как вендоров, так и различных защитных технологий) и являются членами AMTSO). Вот они: AV-Comparatives, AV-Test, Anti-malware, Dennis Technology Labs, MRG EFFITAS, NSS Labs, PC Security Labs и Virus Bulletin

- Учитываются только вендоры, участвовавшие в 35% тестов и более, иначе можно получить «победителей» выигравших один единственный за всю свою «историю болезни» тест (а это гарантированный говно-маркетинг).

- Подробное объяснение методологии в этом видео и в этом документе.

- Если кто-то считает методики подсчёта результатов некорректными – добро пожаловать в комменты.

- Если кто-то в комментах будет возбухать «а, сам себя не похвалишь – никто не похвалит», отвечаю: предложите и обоснуйте свою методику.

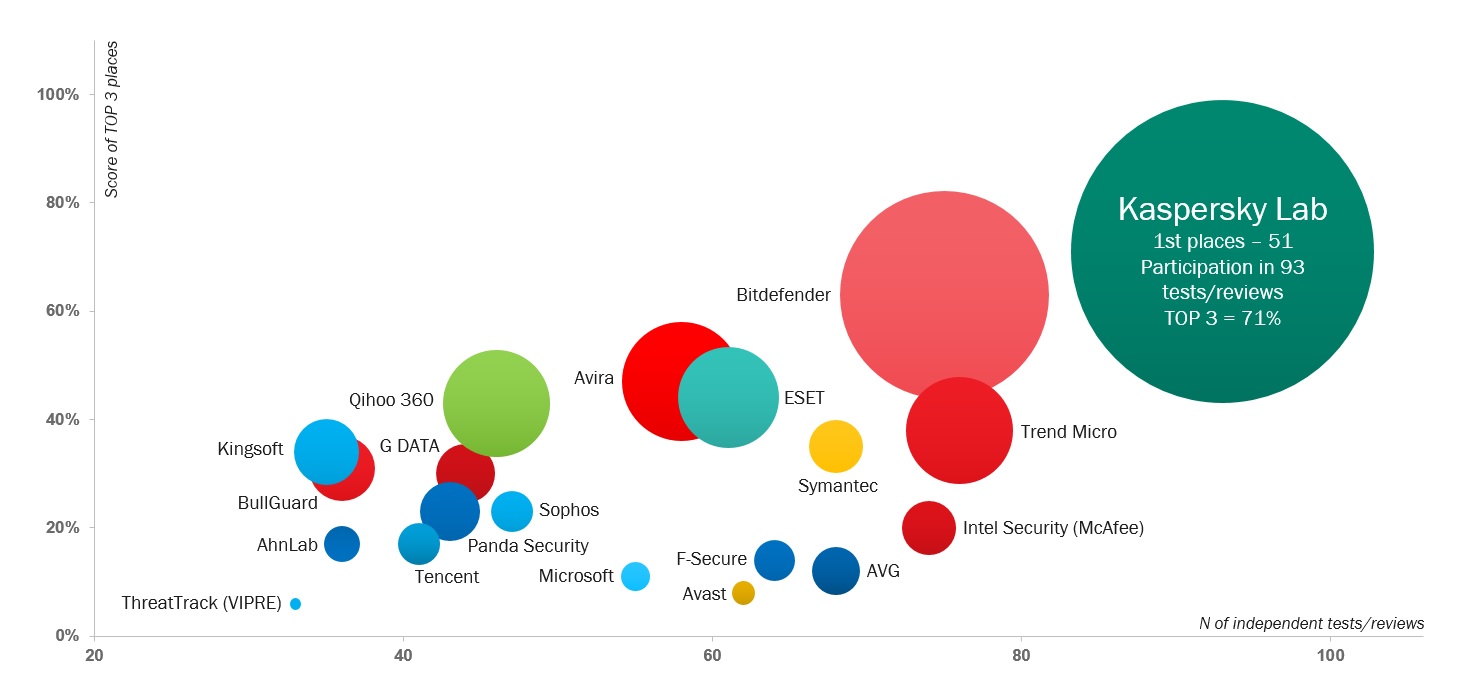

Итак, анализируем результаты тестов за 2014 год и – бьют барабаны, замирает и перестаёт дышать и моргать восхищённая публика… – и получаем вот такую картинку мира:

Здесь по абсциссе число тестов, в которых вендор принимал участие и итоговых полученных наград; по ординате – процент попадания вендора в первые три позиции (TOP3). А диаметр окружности – это количество абсолютных побед.

Ну, что же, поздравляю наш R&D и всех-всех остальных сотрудников компании, а также наших партнёров, клиентов, подрядчиков, наших просто друзей/подруг и всех членов их семей! Поздравляю всех с заслуженной, достойной и наглядной победой! Так держать, спасение мира не за горой!! Ура!

Но это ещё не всё! Впереди десерт для ума настоящих знатоков антивирусной индустрии, ценящих изменение данных в динамике.

Описанная выше методика применяется уже три года. И вот тут очень интересно с её помощью разобраться с вопросом об «одинаковости стиральных порошков». Да, есть такое мнение, что все антивирусы уже более-менее одинаковы по уровню защиты и функционалу. И вот какие любопытные наблюдения вылезают из этой оценки:

- Тестов стало больше (в среднем в 2013г. вендоры участвовали в 50 тестах, в 2014г. уже в 55), побеждать стало сложнее (средний показатель попадания в TOP3 тестов уменьшился с 32% до 29%).

- В аутсайдерах по снижению показателя попадания в призёры тестов – Symantec (-28%), F-Secure (-25%) и Avast (-19%).

- Наоборот, свой рейтинг по TOP3-показателям больше всего подняли Trend Micro (+16%), ESET (+12%) и Panda (+11%).

- Любопытно — позиции вендоров относительно друг друга меняются не так значительно. Только 2 вендора изменили свои позиции по количеству TOP3-мест более чем на 5 пунктов. Это доказывает, что качественная защита определяется не только сигнатурами, она выстраивается годами и воровство детекта решающего преимущества не даст.

- Изощренным любителям статистики будет также интересно узнать, что 7 первых вендоров по TOP3-рейтингу занимали призовые места в 2 раза больше, чем остальные 13 вместе взятые (240 попаданий в TOP3 против 115) и забрали 63% всех «золотых медалей».

- При этом 19% всех «золотых медалей» взял один единственный вендор – угадайте кто? :)

Ну, и главный вывод.

Тесты — это один из важнейших критериев для выбора защиты. Разумеется, пользователь скорее поверит авторитетному мнению со стороны, чем красивому буклету («всяк кулик своё болото хвалит»). Все вендоры это хорошо понимают, но каждый решает проблему в меру своих технологических способностей. Некоторые действительно «парятся» по поводу качества, постоянно совершенствуют защиту, а кое-кто манипулирует результатами. Получили единственный за год сертификат соответствия, нацепили на лацкан медальку и вроде как уже лучше всех. А надо смотреть на картинку целиком, оценивая не только результаты тестов, но и процент участия.

Посему пользователям рекомендуется выбирать защиту вдумчиво и не позволять вешать себе на уши клюкву :)

Методика оценки результатов независимых тестов антивирусов от @e_kasperskyTweet

На этом всем спасибо за внимание и до новых встреч!